映像解析技術を核とした作業認識ソリューション

ハイライト

製造業の革新がグローバルに進展する中,日立はAIを活用し,膨大な映像データからヒトの行動や動作特徴をリアルタイムに認識する映像解析技術を開発し,製造現場への適用を進めている。目的に応じて,製造フロアにおけるヒトの位置や動線,組立作業などにおけるヒトの作業動作,顕微鏡を使用した微細加工の手技など,さまざまな粒度のヒトの作業を非接触・リモートで認識する。このような製造現場のヒト作業の認識結果を4Mデータの一つとして活用することで,製造業における作業品質,生産性,安全性の向上を実現する。

1. はじめに

Industrie 4.0構想を端緒とした製造業の革新がグローバルに進展している。これはヒト,モノ,システム,企業などがつながることで価値創出を図るものであり,製造現場の見える化から究極的にはサプライチェーン全体での品質改善や生産性向上をめざしている。

日立は,製造現場の4M(Human,Machine,Material,Method)データをセンシングし,つなげて分析し,具体的な指示や制御を行う,Sense-Think-Actの継続的実行が,製造業革新の要諦と考えている。特に,従来は定量的なデータを取得できていなかった製造現場のヒトに着目し,映像解析技術を応用して,組立作業動作の逸脱検知や,熟練技能のデジタル化などの技術を開発・提供してきた1),2)。

近年では自然災害の頻発や新型コロナウイルス感染症の流行により,リモートや非接触環境下での業務の維持・継続が課題となっている。製造現場においては,自動化を進めるとともに,自動化を進めてもなお残るヒト作業を非接触・リモートで監督・支援することの必要性が高まっている。また,5G(5th Generation)ネットワーク技術やエッジコンピューティング技術の進展により,製造現場においても大量の映像データを解析することが容易になってきた。映像解析技術を活用した,製造現場の生産性・品質・安全性の向上への期待が高まっている。

2. 製造現場における作業認識

2.1 作業認識ソリューションの分類

前述した製造業の期待に応えるため,日立は製造現場のヒト作業を認識するソリューションを提供している。一口に製造現場の作業と言っても,製造するモノ(Material)や製造の形態(Method)によってさまざまな作業動作が存在する。そこで,認識する作業の大きさ(粒度)や特徴量に応じて,作業認識のメニューをそろえている。作業の粒度は,次の三つに大別される。

- 位置・動線

製造フロアのどの位置で作業していたかを捉える。 - 姿勢・動作

どのような姿勢や動作で作業をしていたかを捉える。 - 微細動作

精密部品の微細加工などでどのような動作をしていたかを捉える。

そして,作業認識の活用目的に応じて,例えば次のような特徴量を認識する。

- 生産性向上(作業着手・完了時刻,作業時間)

- 品質向上(標準作業手順からの逸脱有無,位置・速度など道工具の動かし方)

- 安全性向上(作業禁止区域への立ち入り有無,不安全姿勢の発生頻度)

次節では,作業の粒度に応じたソリューションのユースケースについて説明する。

2.2 位置・動線の認識

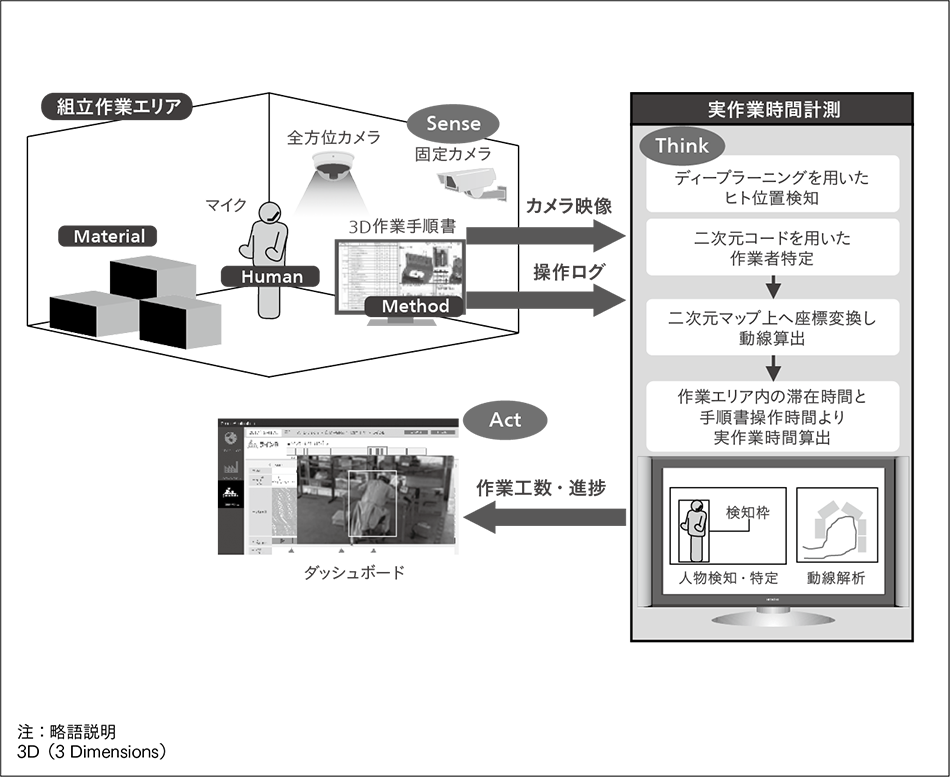

本ユースケースは,作業者に負担をかけずに組立作業エリア内での実作業時間を計測するものである。図1に示すように,作業者は音声入力により3D(3 Dimensions)作業手順書を操作しながら,作業エリア内で製品を組み立てる。手順書の操作ログでおおよその作業時間を捉えることはできるが,何らかの事情で作業中に作業者がエリアを離れた場合などに正確な作業時間を計測できないという課題があった。

そこで,この作業エリアに複数のカメラ(Sense)を設置し,映像解析によるヒト位置の認識結果(Human)と手順書の操作ログ(Method)を統合することで,組立作業の実作業時間を計測することとした。ヒト位置の認識は,ディープラーニングによるヒトの検知と,二次元コードを用いたヒトの特定の組み合わせで実現している。ディープラーニングにより映像内の人物領域を検出し,人物領域内の二次元コードを検出してID(Identification)を特定することでヒトを特定する。その後,あらかじめ設定した作業エリアの領域内での滞在時間を積算し,操作ログと組み合わせて作業時間を算出する。

開発技術の有効性を検証するため,現場の実作業に対してヒト位置認識による実作業時間計測を適用した。その結果,実作業時間を平均誤差3%内で計測できることを確認した。

位置・動線の認識は,前述の生産性向上に向けたセル生産における作業者の作業時間計測,ライン生産における監督者や部品供給者の作業時間計測に加えて,安全性向上の観点から危険エリアへの入場管理などにも適用できる。

2.3 姿勢・動作の認識

本ユースケースは,作業者や監督者に負担をかけずにライン作業における各工程の作業時間を計測するものである。従来はライン上でワークを流すコンベア(Machine)の動作信号を解析することで各工程へのワークの到着・出発時刻を計測し,作業時間を推定していた。しかし,各工程が同期して動くライン作業では,前後工程の状況によって作業者が手待ち状態になることがある。そのため,正確な実作業時間を計測するためには,作業者による作業開始・終了の入力や監督者の目視による計測が必要であった。

そこで,各工程に作業者を撮影するカメラを設置して,作業者の姿勢(例えば,手の位置)の時間的な変化から,作業状態を認識することとした。これにより,例えば,コンベア上のワークに対して作業している姿勢とコンベア上にワークがなく手待ち状態になっている姿勢とを識別する。

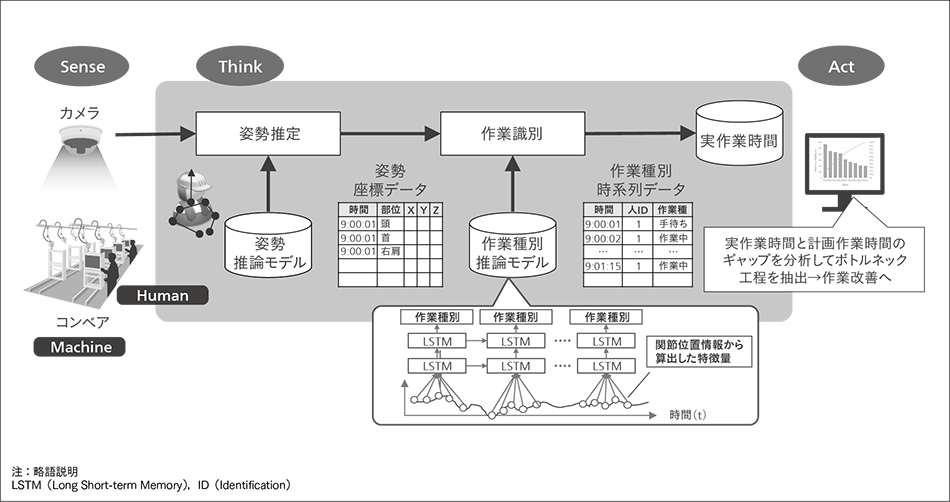

実作業時間計測アルゴリズムの全体像を図2に示す。姿勢推定部では,作業映像の各フレームを入力としてディープラーニングによる姿勢推定を行い,作業者の関節位置情報を推定する。作業識別部では,姿勢推定部で推定した関節位置情報から算出した特徴量の時系列データを入力として,ディープラーニングによる作業識別を行い,その作業者が「作業中」であるか,「手待ち」であるかといった作業状態を識別する。作業識別部では,時系列データの解析で実績のあるLSTM(Long Short-term Memory)をベースとしたニューラルネットワークを構築した。この作業識別結果(Human)とコンベア(Machine)の動作信号を組み合わせて,実作業時間を計測する。

開発技術の有効性を検証するため,現場の実作業に対して実作業時間計測を適用した。その結果,タクトタイム180秒の組立作業において,「作業中」と「手待ち」を識別することで,実作業時間を誤差±3秒内で計測できることを確認した。計測した実作業時間をさらに分析することで,例えば,各工程の作業改善やラインバランスの最適化を行い,生産性向上につなぐことができる。

姿勢・動作の認識は,前述のライン生産における各工程の実作業時間計測に加え,品質向上の観点から標準作業手順からの逸脱検知,安全性の観点から危険姿勢の検知などにも適用できる。

2.4 微細動作の認識

本ユースケースは,顕微鏡下の微細な手作業をサブミリ精度(0.1~1 mm程度の精度)で三次元定位するものである。精密機器の微細加工といった熟練手技を必要とする作業者の育成において,従来は定性的な指導が中心であり,手技の結果としての出来栄えを確認しながら試行錯誤を繰り返して,手技を習得させていた。そのため,技能者の育成に数か月を要していた。

そこで,微細な動作をデジタル化し,熟練作業者と一般作業者の手技を比較できる微細動作の認識システムを開発した。これにより,技能者を早期に育成し,作業品質の高位平準化を図る。

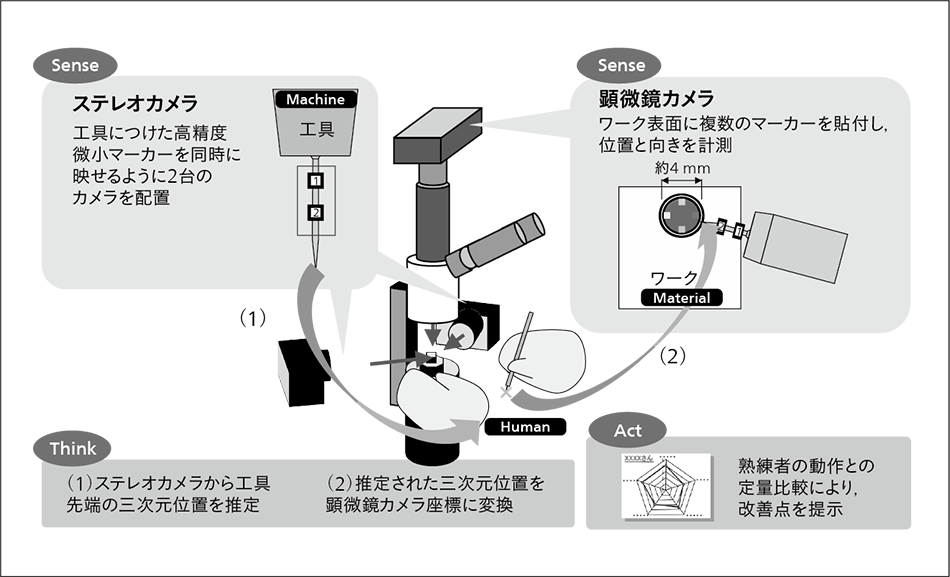

微細動作の認識システムの構成を図3に示す。ステレオカメラとして作業者の手元に2台のカメラを設置し,作業者が持つ工具に取り付けた二つの高精度微小マーカーを2台のカメラに同時に映るように撮影する。顕微鏡カメラは,作業者が使用する顕微鏡の鏡筒に取り付けたカメラであり,作業者が作業中に見ている映像を撮影する。そこには,複数のマーカーを取り付けたワークが映る。

ステレオカメラで工具の二つのマーカーの三次元位置を計測して,工具の先端位置を推定する。そして,推定した先端位置を顕微鏡カメラ座標に変換する。これには事前のキャリブレーションにより取得した,ステレオカメラと顕微鏡カメラで撮影した映像間の幾何的な関係を用いる。さらに顕微鏡カメラでワークのマーカーを計測して,ワークに対する工具の繊細な動きをサブミリ単位で得る。

開発技術の有効性を検証するため,現場の実作業に対して微細動作の認識を適用した。その結果,約4 mmのワーク領域に対する作業動作(工具先端位置)をサブミリ精度で定位できることを確認した。今後は,熟練作業者と一般作業者の動作の比較や,作業品質との相関分析により,熟練技能者の早期育成に活用していく。

3. 今後の展望

近年のディープラーニング技術の急速な進化に伴い,作業認識に活用できるさまざまな映像解析技術が日々提案されている。また,慣性センサーなどのセンサーを搭載した,シャツ型など多様な形態のウエアラブルデバイスも登場してきている。製造現場の課題を迅速に解決するためには,このような技術を適切に組み合わせ,システム化する必要がある。

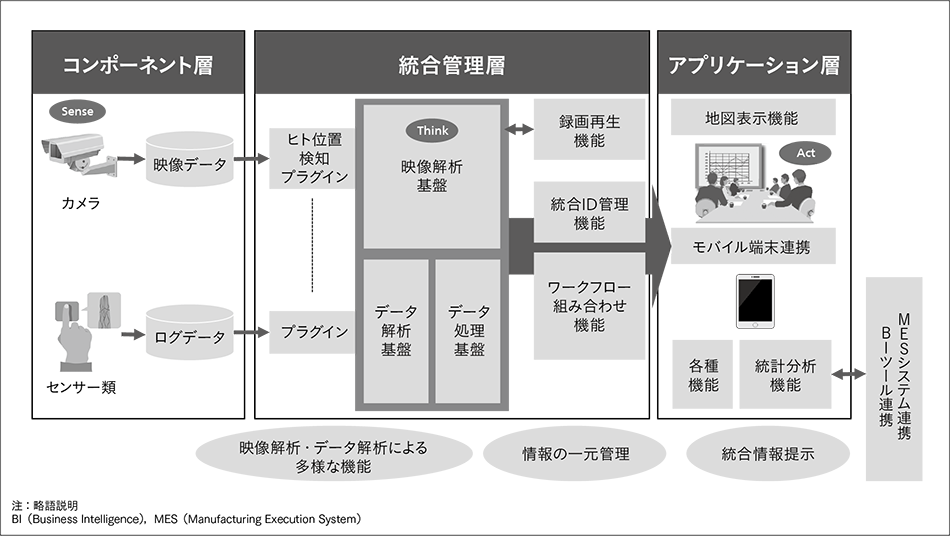

株式会社日立産業制御ソリューションズは,映像データや各種IoT(Internet of Things)データを統合的に収集,蓄積,解析するフィジカルセキュリティ統合プラットフォーム(以下,「統合PF(Platform)」と記す。)を開発,提供している3)。さまざまな映像解析技術をモジュール化し,統合PFのプラグインとして提供することで,迅速に映像解析システムを構築できる(図4参照)。日立は,統合PFと他のシステムを連携することにより,解析したヒト(Human)データと製造現場の4Mデータをつなぎ,製造現場の課題解決に活用していく。

さらに,5Gといったネットワーク技術の進展により,工場内での広帯域高速ネットワークの構築が容易になり,映像解析技術の活用環境が整いつつある。ただし,膨大な映像データすべてを一つのプラットフォーム上で収集・蓄積・解析するのはコスト的に現実的でない。製造現場に近い場所,すなわちデータの発生源であるカメラの近傍(エッジ)で,リアルタイムに映像解析を行う技術も必要となってくる。このように,エッジコンピューティングや5Gネットワークを適切に活用して低コストで迅速なソリューションを提供する技術も確立していく。

そして,このようにして収集した各現場の4Mデータを,「IoTコンパス」4)によってサプライチェーンを構成する業務や組織の間でつないでいき,サプライチェーン全体の生産最適化・品質向上に生かしていく。

4. おわりに

本稿では,製造現場の生産性向上,品質向上,安全性向上に向けて,ヒトの位置・動線,姿勢・動作,微細動作を対象とする映像解析技術を活用した作業認識の取り組みを紹介した。今後は,エッジ・クラウド連携技術により,低コストで迅速なソリューション提供をめざしていく。

謝辞

本稿で述べた作業認識ソリューションの開発においては,ダイキン工業株式会社をはじめとする関係各位より多くのご支援を頂いた。深く感謝の意を表する次第である。

参考文献など

- 1)

- 井坂英也,外:センシング技術と解析技術を活用した次世代グローバル製造管理,日立評論,98,3,184~187(2016.3)

- 2)

- 梅木春男,外:センシング技術を活用した製造現場ノウハウのデジタル化,日立評論,99,6,626~631(2017.11)

- 3)

- 沖田英樹,外:安全・安心な社会の構築に貢献するAI技術を用いた映像解析ソリューション,日立評論,102,3,400~405(2020.5)

- 4)

- 伊藤大輔,外:生産現場を改善し続けるデジタルツイン技術,日立評論,102,3,358~361(2020.5)